Hvad kræver EU's AI-forordning af højrisikosystemer?

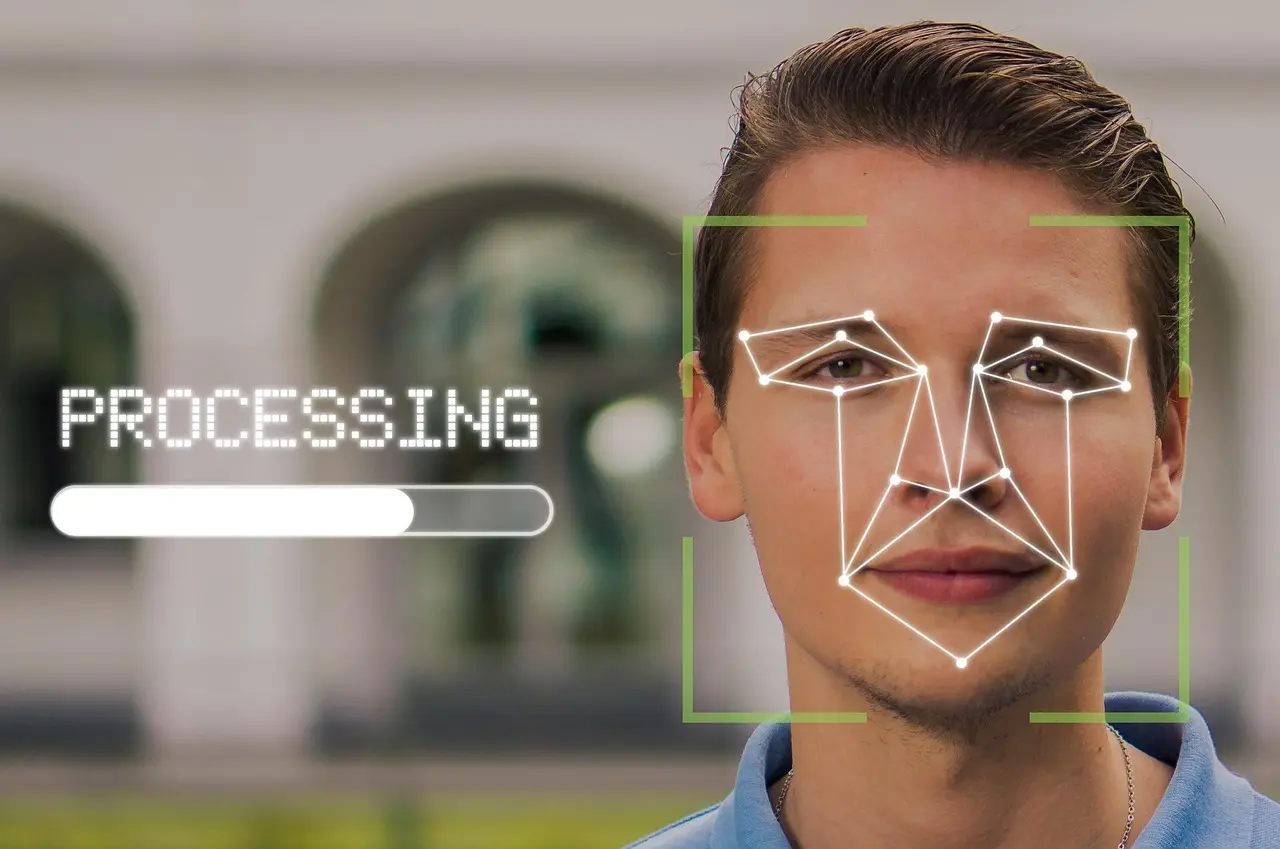

Ansigtsgenkendelse i lufthavnen, algoritmer der afgør din låneansøgning, og intelligente robotter på hospitalet. Kunstig intelligens kryber hastigt ind i vores hverdag - og EU har besluttet, at de mest indgribende løsninger nu skal spille efter helt nye regler.

Med den kommende AI-forordning introducerer EU et skarpt skel mellem “nice-to-have”-algoritmer og højrisikosystemer, hvor fejl kan koste både menneskeliv, rettigheder og samfundstillid

Kravene spænder fra risikostyring og gennemsigtighed til CE-mærkning og løbende overvågning - og ansvaret hviler ikke kun på udviklerne, men også på brugere, importører og distributører.

I denne artikel gennemgår vi, hvad der egentlig gør et AI-system “højrisiko”, og hvordan du som virksomhed eller offentlig aktør konkret opfylder de nye krav. Vi samler de juridiske paragraffer, de tekniske standarder og de praktiske trin i én overskuelig guide, så du kan komme foran compliance-kurven, før reglerne for alvor slår igennem.

Har du styr på, om din næste algoritmeudrulning kræver en fuld EU-overensstemmelseserklæring - og hvad det i givet fald betyder for dit data-setup, din dokumentation og dit budget? Læs videre og få svaret.

Hvad er et højrisikosystem under EU’s AI-forordning?

EU’s AI-forordning (AI Act) opererer med en skarp todeling, når et system skal vurderes som “højrisiko”. Først er der produktsporet, hvor en AI-funktion udgør en sikkerhedskomponent i produkter, der i forvejen reguleres af sektorspecifikke direktiver eller forordninger - f.eks. medicinsk udstyr, legetøj, maskiner, jernbane- og luftfartssystemer. Dernæst er der bilag III-sporet, som rammer bestemte anvendelser, uanset om de indgår i et fysisk produkt eller leveres som ren software. Klassificeringen er afgørende, fordi den automatisk udløser det komplette sæt af højrisikokrav, uanset om løsningen er udviklet internt, integreret fra en tredjepartsmodel eller baseret på en generel-formåls-/foundation-model (GPAI).

Produktsporet (AI som sikkerhedskomponent) kickstarter højrisiko-regimet, hvis AI’en kan påvirke den overordnede sikkerhed eller overensstemmelse for et CE-mærket produkt. Eksempler er et computer-vision-modul, der styrer en kirurgisk robot, eller et adaptivt bremsesystem i en autonom gaffeltruck. Her skal AI-kravene leve side om side med de “gamle” produktkrav: harmoniserede standarder, tekniske filer og den velkendte CE-proces. Det betyder, at producenter typisk vil udvide deres eksisterende kvalitetsstyringssystem (ISO 13485, ISO 9001, etc.) med de nye AI-specifikke kontroller for datahåndtering, menneskeligt tilsyn og robusthed.

Bilag III-sporet (specifikke anvendelser) favner en bred vifte af use cases, hvor risikoen er knyttet til samfundsmæssige rettigheder snarere end fysisk sikkerhed. Forordningen nævner otte tematiske kasser, som alle automatisk er højrisiko:

- Biometrisk identifikation og kategorisering i det offentlige rum

- Drift af kritisk infrastruktur (fx energi, vand, transport)

- Uddannelse og erhvervsmæssig træning (fx scoring af prøver)

- Beskæftigelse, HR og arbejdsstyring (fx rekrutteringsscreening)

- Kreditvurdering og adgang til essentielle tjenester (bank, forsikring, sundhed)

- Retshåndhævelse (fx predictive policing, kriminalitets-analyse)

- Migration, asyl og grænsekontrol

- Retssystemet og demokratiske processer (fx domstolsanalyse, stemmeindflydelse)

Roller og ansvar er præcist defineret: udbyder (provider) hæfter for design og CE-mærkning; deployer/bruger skal sikre korrekt anvendelse, løbende overvågning og i visse tilfælde en vurdering af grundlæggende rettigheder; importør, distributør og bemyndiget repræsentant har tilsvarende pligter som i klassisk produktlovgivning. Når en GPAI-model indlejres i et højrisikosystem, skal modeludbyderen levere fuld Model Card, evalueringsdata og risikorapporter, så systemudbyderen kan udfylde sin tekniske dokumentation. Samtidig kan andre regelsæt - især GDPR, NIS2 og sektorlovgivning - stille parallelle krav til databeskyttelse, cybersikkerhed og audit. Gråzonerne opstår typisk, hvor en AI-funktion både har produkt- og bilag III-karakter (fx et kamera i et hospital, som både styrer robotter og udfører biometrisk adgangskontrol), og her kræves en tidlig juridisk og teknisk fortolkning for at undgå compliance-gab.

Hvilke krav gælder – og hvordan efterlever man dem i praksis?

EU’s kommende AI-forordning opstiller et fast sæt af kernekrav til alle højrisikosystemer. Helt centralt er et kvalitets- og risikostyringssystem, der dækker hele livscyklussen fra design til udfasning. Systemet skal bl.a. sikre:

- Datastyring - datasæt skal være relevante, repræsentative og fri for unødig bias; datakilder, rensning og validering skal dokumenteres.

- Teknisk dokumentation & EU-overensstemmelseserklæring - detaljeret beskrivelse af model, træning, test, performance og begrænsninger.

- Logning og sporbarhed - løbende log af input, output og systembeslutninger, så fejl kan efterspores.

- Gennemsigtighed & brugsanvisning - klare instruktioner til brugere om systemets formål, drift og kendte risici.

- Menneskeligt tilsyn - kvalificerede operatører skal kunne gribe ind, suspendere eller overstyre systemet.

- Nøjagtighed, robusthed & cybersikkerhed - mål for præcision, fail-safe-mekanismer og beskyttelse mod angreb skal defineres og testes.

For at komme på markedet skal udbyderen gennemføre en overensstemmelsesvurdering. De fleste højrisikokategorier kan bruge selvcertificering, men systemer, der fx falder under medicinsk udstyr eller biometrisk fjern-identifikation, kræver en tredjeparts-vurdering hos et bemyndiget organ. Når kravene er opfyldt, følger:

- Registrering i den centrale EU-database for højrisiko-AI

- Pålæsning af CE-mærket

- Løbende markedsovervågning, indberetning af alvorlige hændelser (15 dage) og årlig eftermarkedsovervågning

Kravene stopper ikke ved udbyderen. Deployere (brugere) skal sikre korrekt konfiguration, personale-kompetencer og opbevare logdata i mindst 6 år. De skal desuden udføre en vurdering af grundlæggende rettigheder, hvis systemet anvendes til biometrisk identificering, kritisk infrastruktur eller beslutninger med væsentlig indvirkning på personer. Importører og distributører skal kontrollere CE-mærke og dokumentation, opbevare dem i 10 år og samarbejde med tilsynsmyndigheder ved forespørgsler.

En praktisk roadmap kan typisk se sådan ud:

- Klassificér use cases og bekræft højrisiko-status.

- Lav en gap-analyse op mod forordningens artikel 9-15 krav.

- Etabler eller tilpas QMS og datastyrings-procedurer; vælg modelkort og bias-tests.

- Vælg overensstemmelsesvej (selv eller tredjepart), udpeg compliance-ansvarlig og planlæg audit trails.

- Udarbejd teknisk dokumentation, foretag performance- og cybersikkerhedstests, og indgå aftaler om leverandørdata/foundation-modeller.

- Planlæg drift, monitorering og rapportering - inkl. incident-håndtering.